采集管理¶

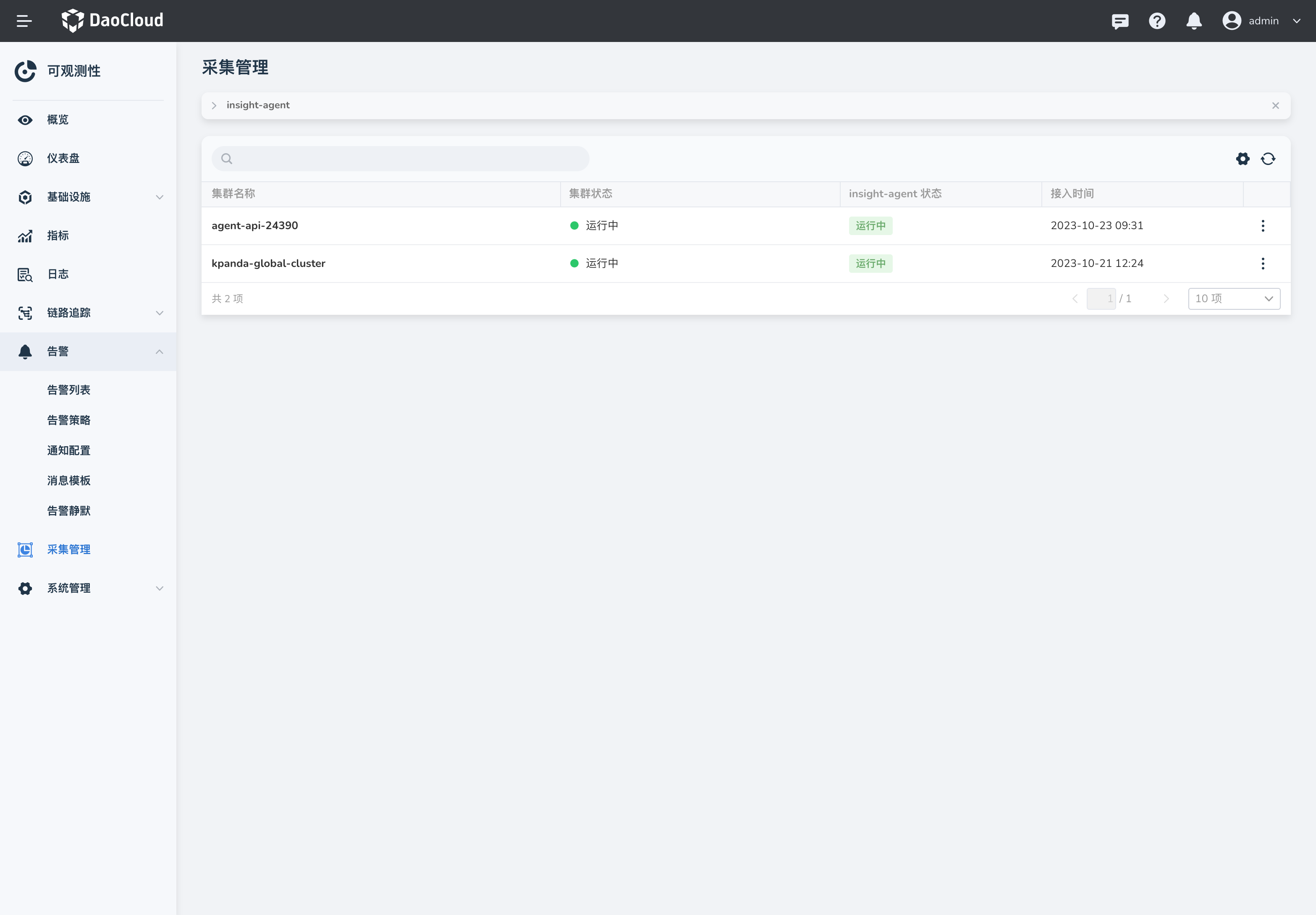

采集管理 主要是集中管理、展示集群安装采集插件 insight-agent 的入口,帮助用户快速的查看集群采集插件的健康状态,并提供了快捷入口配置采集规则。

具体操作步骤如下:

-

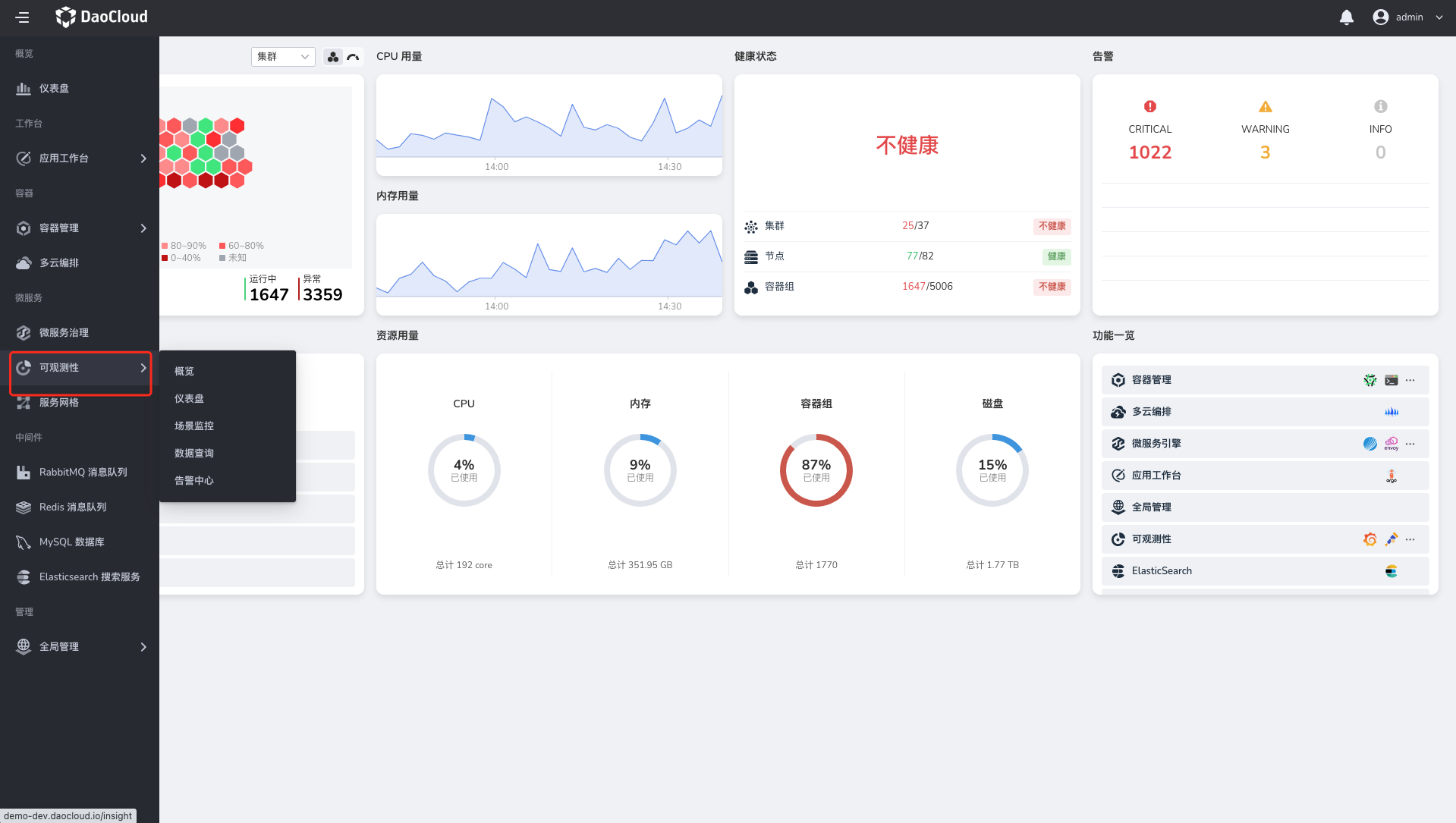

点击左上角的,选择 可观测性。

-

选择左侧导航栏的 采集管理,查看全部集群采集插件的状态。

-

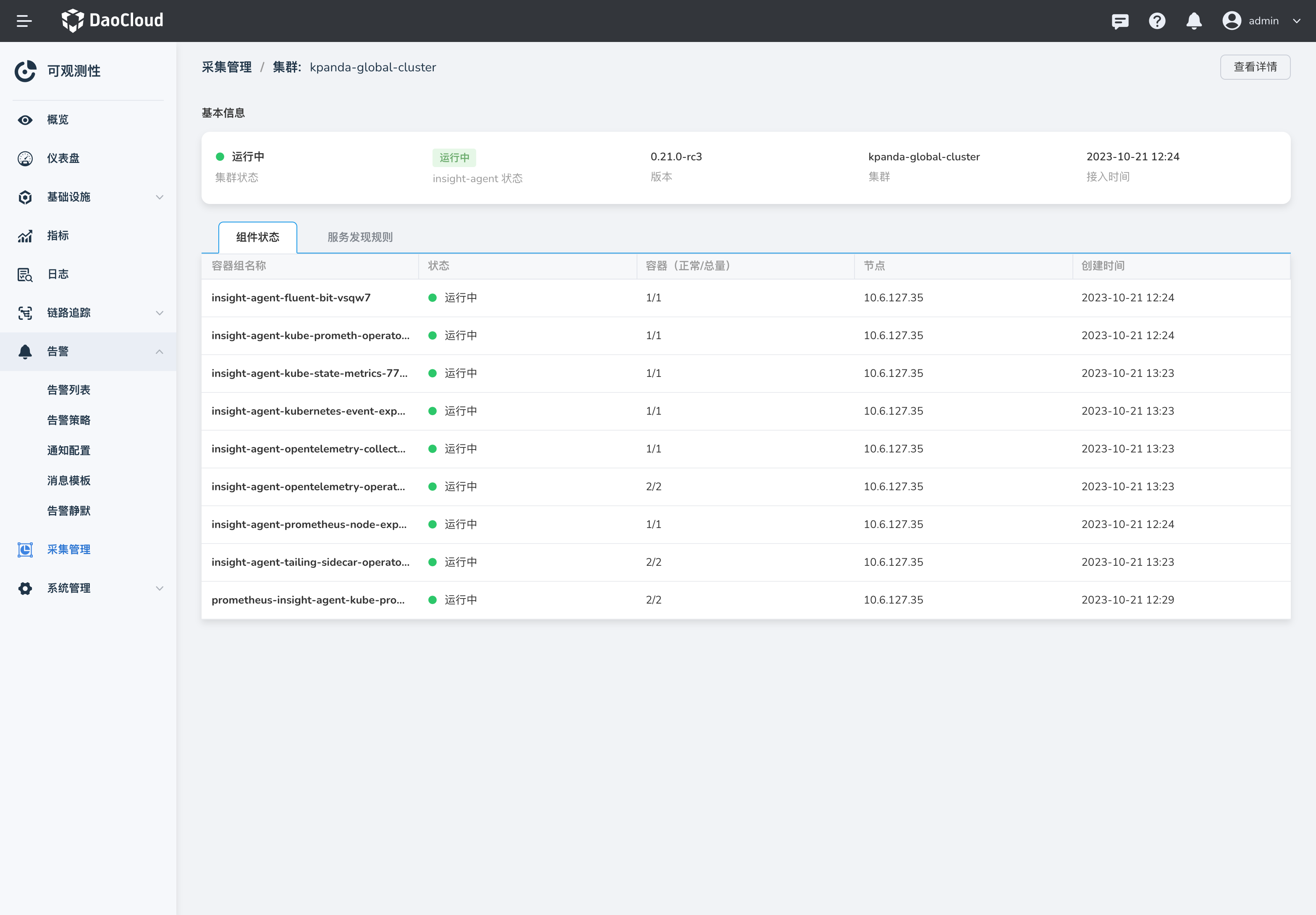

集群接入 insight-agent 且处于运行中状态时,点击某个集群名称进入详情。

-

在集群的采集详情页,选择 指标采集状态 页签,可以看到当前集群 Prometheus 采集的 Target 的详细状态以及每个 Target 的标签。

-

在 服务监控 页签中,点击快捷链接跳转到 容器管理 -> 自定义资源 添加服务发现规则。